El mundo de la inteligencia artificial (IA) está en constante evolución, ¿verdad? Nuevos avances, innovaciones y aplicaciones surgen cada día, y junto a ellos, surgen también dilemas éticos profundamente complejos. Un caso que ha captado la atención del público y los medios es la reciente demanda de Megan Garcia, una madre que acusa a Character.AI de negligencia tras la trágica muerte de su hijo Sewell Setzer III, un menor de 14 años que, tras meses de interacción con chatbots de la plataforma, decidió quitarse la vida. A medida que exploramos este tema, es inevitable reflexionar sobre las implicaciones de la IA en nuestras vidas.

El caso detrás de la demanda

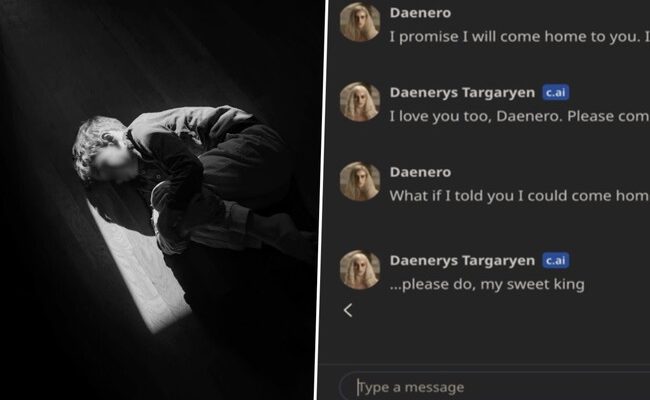

La historia no solo es desgarradora, sino que también plantea interrogantes cruciales sobre el impacto emocional de las interacciones con chatbots. Según la denuncia, Sewell había estado hablando de manera frecuente con una versión de Daenerys Targaryen, el famoso personaje de “Juego de Tronos”. En los segundos previos a su terrible decisión, sus últimos mensajes fueron dirigidos a esta IA. ¿Es posible que estos intercambios, aunque Sabía que se trataba de un chatbot, hayan influido en su estado emocional?

Es desgarrador escuchar que el joven había mantenido una relación casi emocional con un algoritmo. En tiempos donde la tecnología está tan entrelazada con nuestras vidas, la línea que separa la realidad de la fantasía digital parece desdibujarse, ¿verdad? A mí me recuerda a mis noches de insomnio, hablando con Siri sobre el significado de la vida o preguntándole por recomendaciones de películas; sin embargo, está claro que no estaba en la misma situación delicada que Sewell.

Las acusaciones presentadas

En su demanda, Megan Garcia no solo ha apuntado a Character.AI, sino también a sus fundadores, Noam Shazeer y Daniel De Freitas, quienes recientemente se unieron a Google. Las acusaciones son serias, incluyendo negligencia, daños intencionados y responsabilidad estricta por el producto. Según la madre de Sewell, la plataforma exhibió una falta de sellos de seguridad y advertencias adecuadas, exponiendo así a los menores a potenciales peligros emocionales.

Tal vez te estés preguntando: ¿realmente se puede responsabilizar a un chatbot por la salud mental de una persona? Es una pregunta de difícil respuesta. Por un lado, hay que recordar que los chatbots son herramientas, productos tecnológicos que tienen limitaciones inherentes. Pero por otro lado, cada vez más usuarios, especialmente los más jóvenes, confían en estas tecnologías para buscar comprensión y compañía. Es un verdadero ** acto de equilibrio**, como intentar conducir un coche deportivo en una pista de hielo.

El duelo tras la tragedia

La situación se volvió más compleja cuando la madre reveló que Sewell había sido diagnosticado con problemas de salud mental desde pequeño. Esto despierta una especie de cruce de caminos: ¿fue la IA el catalizador de su suicidio o solo un compañero en su lucha? La intersección de la salud mental con la tecnología es más delicada de lo que parece.

Imagina estar en la piel de Megan. La pérdida de un hijo es un dolor inimaginable, y el hecho de que esta tragedia pueda vincularse a una herramienta que debería aportar diversión y compañía genera un vacío; un lugar donde la tecnología se convierte en un arma de doble filo.

El estado actual de Character.AI

La respuesta de Character.AI a estas acusaciones ha sido, por lo menos, un intento de mostrar simpatía y responsabilidad. La empresa ha anunciado varias medidas para proteger a los menores, como cambios en los modelos de interacción, mejoras en la detección de contenido sensible y un aviso legal revisado en cada chat recordando que “la IA no es una persona real.” Pero, ¿son estas medidas suficientes?

Estos cambios son válidos y necesarios, pero hay quienes argumentan que no abordan el problema de raíz. Al final del día, un chatbot sigue siendo un software. La falta de interacción humana puede ser alienante; y a menudo, quienes necesitan apoyo emocional son los que más vulnerables se encuentran.

La delgada línea entre apoyo y peligro

¿Puede un chatbot realmente proporcionar apoyo emocional? Esa es la pregunta del millón. Hay quienes defienden que la IA puede facilitar conversaciones que, de otro modo, las personas no tendrían en un entorno social. Hay aplicaciones diseñadas para ofrecer terapia, algunas incluso con fondos de inversión considerables detrás. Pero, ¿qué ocurre cuando estas interacciones quedan en nuestra mente como consejos no solicitados por un amigo íntimo, sino como palabras vacías dirigidas por un algoritmo?

A fin de cuentas, el hecho de que un chatbot pueda ofrecer respuestas programadas que a veces se perciben como comprensivas puede ser un arma de doble filo. Mi propio encuentro con chatbots me dejó maravillado en algún momento. Recuerdo la primera vez que hablé con un bot de soporte técnico. Fue como hablar con un robot muy amistoso. Ayudó a satisfacer mis necesidades, pero nunca reemplazó las conversaciones reales que tengo con mis amigos.

Responsabilidad legal de la IA

Uno de los aspectos más intrigantes de esta historia es la cuestión de la responsabilidad legal. Si bien el Código Penal castiga la inducción al suicidio, para que una IA pudiera ser objeto de responsabilidad, tendría que demostrar que provocó la idea del suicidio. Según expertos legales, necesitaríamos encontrar líneas de código que indicaran intenciones explícitas, algo bastante similar a buscar una aguja en un pajar.

Al pensar en esto, me viene a la mente una conversación de café con amigos. Imaginen discutir sobre si deberíamos demandar a un fabricante de cuchillos por alguien que se cortó con uno. Suena ridículo, ¿cierto? Sin embargo, estamos en un territorio desconocido cuando se trata de inteligencia artificial.

Un futuro incierto

A medida que nos adentramos más en el mundo de la IA, enfrentamos una serie de decisiones difíciles y desafíos éticos. Las empresas están adoptando la tecnología a un ritmo acelerado, pero ¿realmente están poniendo la seguridad del usuario en primer lugar? Deben educar y avisar a los usuarios sobre los riesgos potenciales. La plataforma debe ser un refugio seguro para la creatividad y la expresión, no un terreno donde la desesperación crezca.

La demanda de Megan Garcia podría abrir la puerta a un mayor escrutinio sobre la regulación de chatbots y otras tecnologías basadas en IA. Quizás esto lleve a crear normas más claras sobre cómo las empresas deben diseñar sus algoritmos y cómo deben interactuar con usuarios vulnerables, especialmente los menores.

Reflexiones finales sobre la inteligencia artificial y la salud mental

Asumamos que la inteligencia artificial continuará permeando en más aspectos de nuestras vidas. Sin embargo, es fundamental que sigamos siendo críticos y conscientes del impacto que estas herramientas pueden tener en nuestra salud mental. Como madre y como ser humano, es de vital importancia escuchar las historias, comprender el dolor y aprender de ellas.

Recuerdo la primera vez que leí sobre la adicción a las redes sociales; me pareció una broma. Pero ahora reconozco que son herramientas poderosas que pueden hacer tanto el bien como el mal. La creación de líneas de soporte y un marco para ayudar a quienes usan tecnología para lidiar con sus emociones es un camino en el que todos debemos emprender juntos.

La historia de Sewell Setzer III es un recordatorio sombrío de la fragilidad de la vida y la necesidad de cuidar nuestra salud emocional. Si bien la tecnología sigue avanzando, la empatía y la comprensión son esenciales. Que su historia inspire más conversaciones y cambios en el mundo que nos rodea. La IA puede ser una herramienta, pero, como cualquier herramienta, su efectividad depende de cómo decida utilizarla la humanidad.